stm32

微信

http

机器人平台

微软技术

webpack

框架

IAR

ts

三星线刷

期末考试

图搜索算法

unicode、

赋值运算符

ERP

太空工程师

swiftui

MES系统

类

事务

激活函数

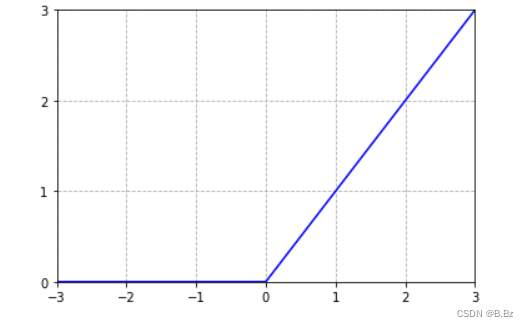

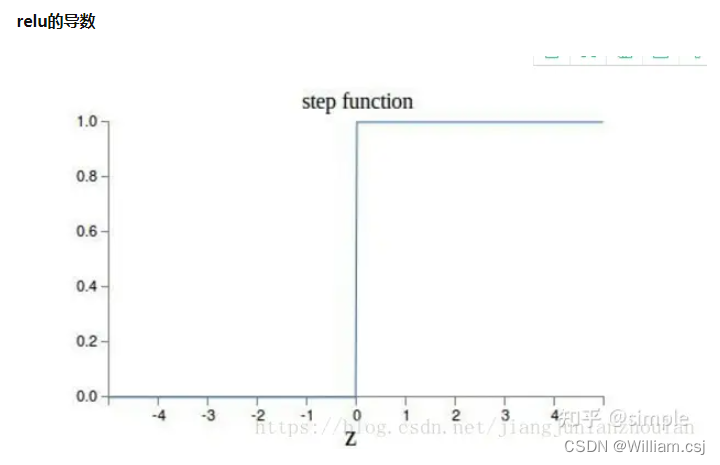

2024/4/11 15:06:38深度学习入门——神经网络激活函数之Relu函数

Relu函数:

import numpy as np

import matplotlib.pyplot as pltdef relu(x):return np.maximum(0, x)x np.arange(-5, 5, 0.1)

y relu(x)plt.plot(x, y)

plt.title(Relu)plt.xlabel(x)

plt.ylabel(y)

plt.show()

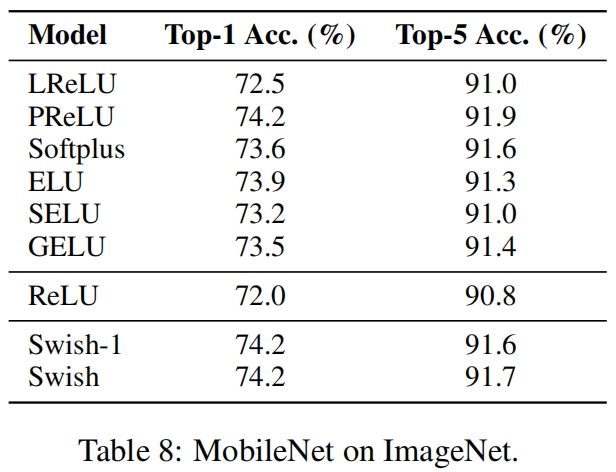

激活函数Swish(ICLR 2018)

paper:Searching for Activation Functions

背景

深度网络中激活函数的选择对训练和任务表现有显著的影响。目前,最成功和最广泛使用的激活函数是校正线性单元(ReLU)。虽然各种手工设计的ReLU替代方案被提出,但由于在…

激活函数总结(四十):激活函数补充(AHAF、SERLU)

激活函数总结(四十):激活函数补充 1 引言2 激活函数2.1 AHAF激活函数2.2 SERLU激活函数 3. 总结 1 引言

在前面的文章中已经介绍了介绍了一系列激活函数 (Sigmoid、Tanh、ReLU、Leaky ReLU、PReLU、Swish、ELU、SELU、GELU、Softmax、Softpl…

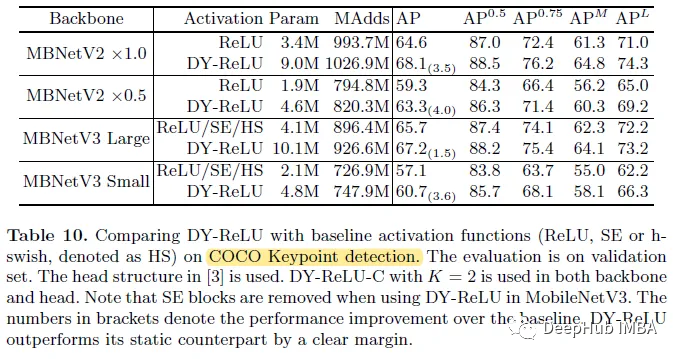

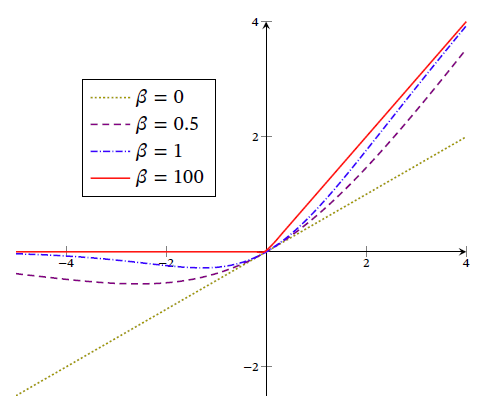

Dynamic ReLU:根据输入动态确定的ReLU

这是我最近才看到的一篇论文,它提出了动态ReLU (Dynamic ReLU, DY-ReLU),可以将全局上下文编码为超函数,并相应地调整分段线性激活函数。与传统的ReLU相比,DY-ReLU的额外计算成本可以忽略不计,但表示能力明显增强&…

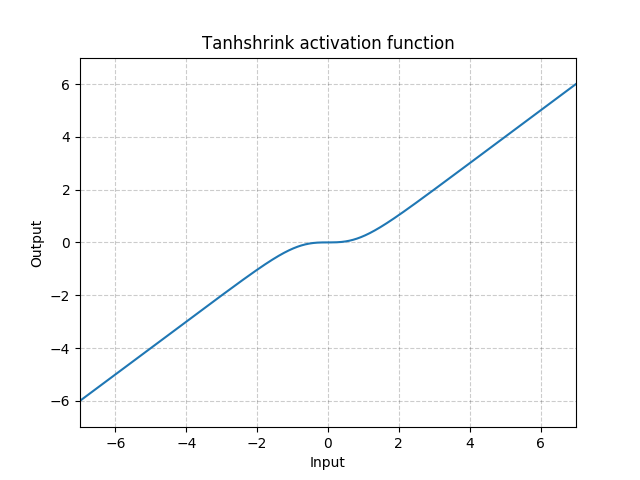

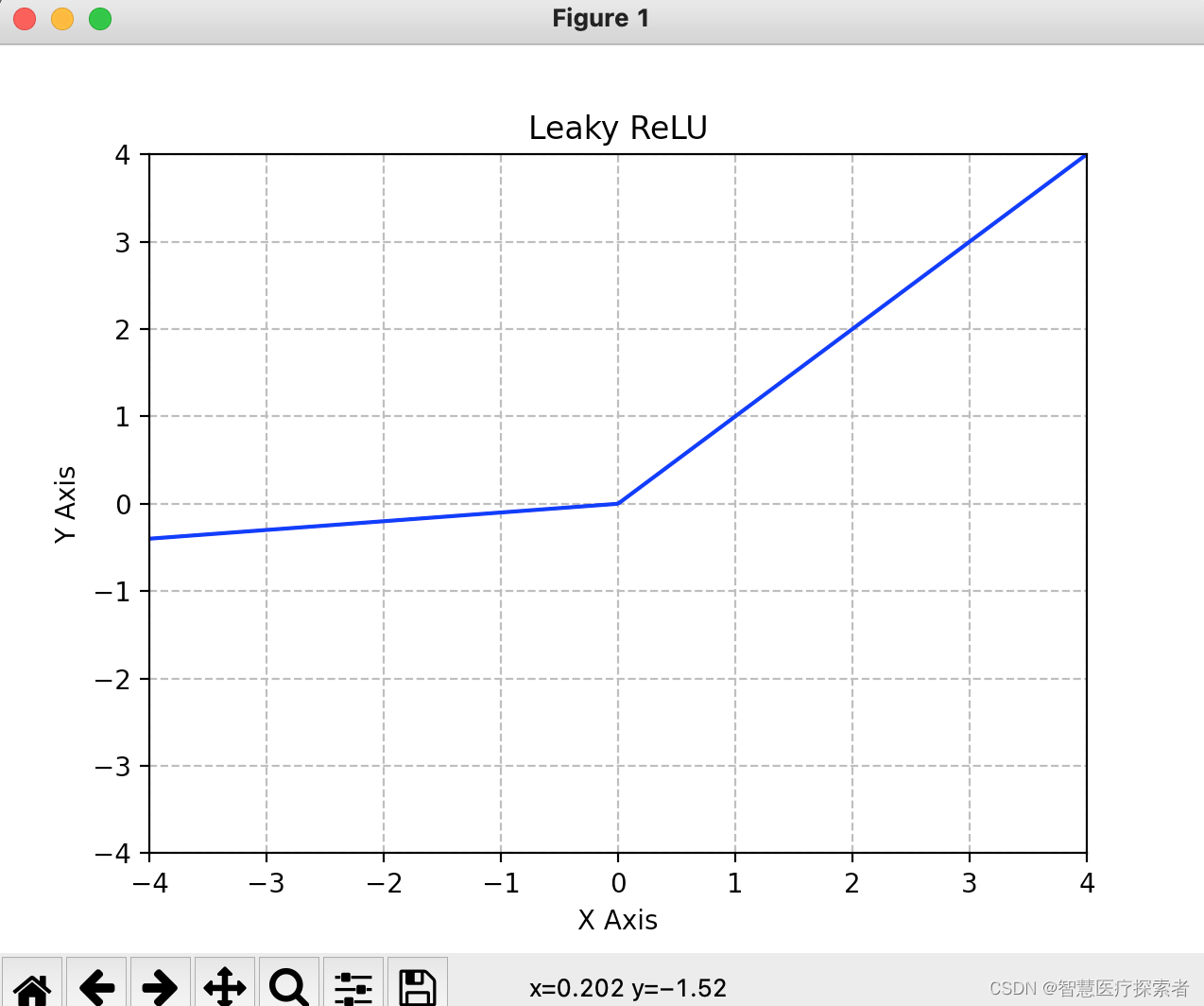

NLP笔记:常用激活函数考察整理

NLP笔记:常用激活函数考察整理 0. 引言1. 常用激活函数 1. sigmoid2. softmax3. relu系列 1. relu2. leaky relu3. elu4. selu5. gelu6. 其他 4. tanh5. 其他 2. 总结3. 参考链接 0. 引言

这篇文章的起因是在于之前考察cross entroy相关的内容的时候,发…

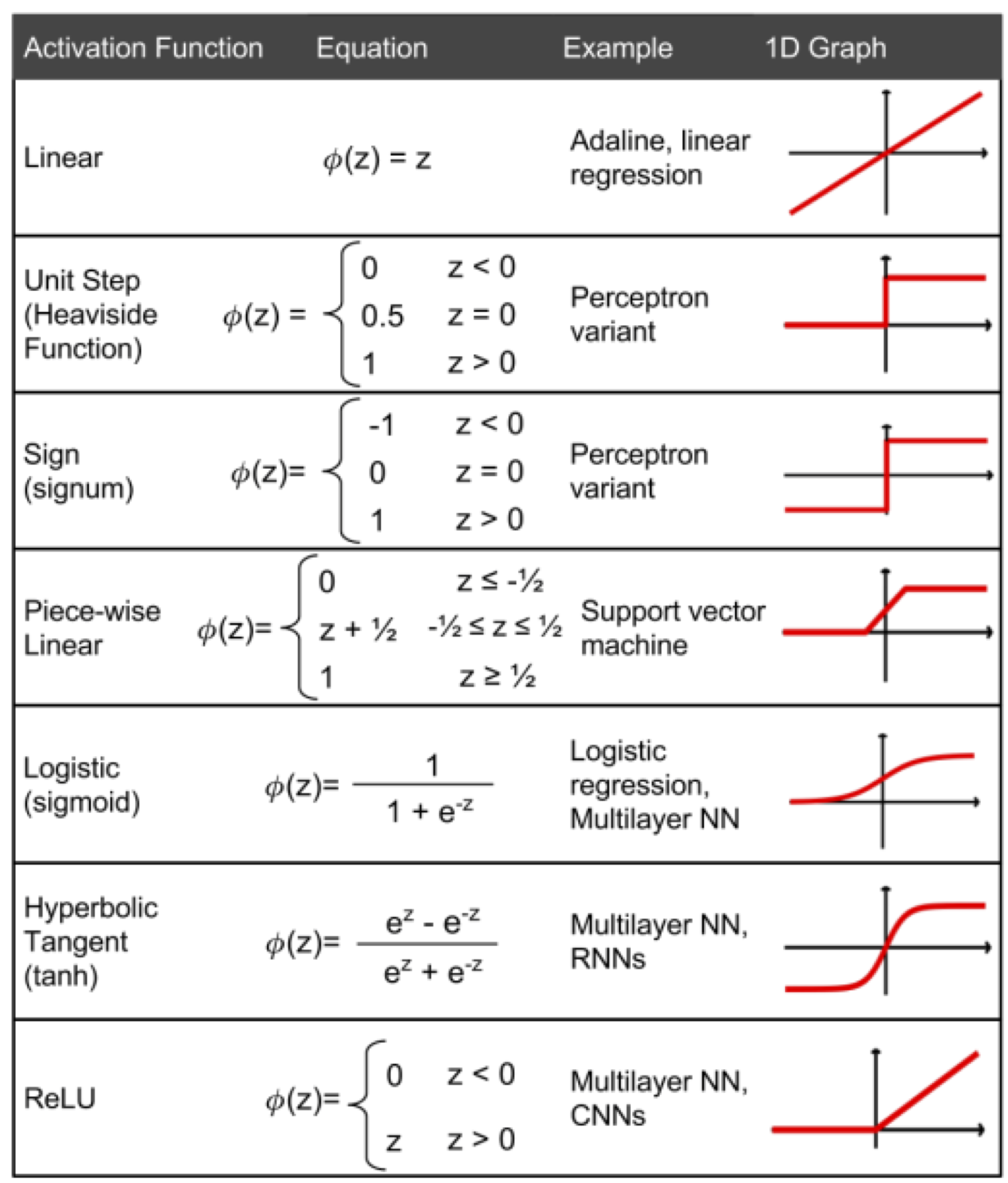

TensorFlow常用激活函数及其特点用法(6种)详解

每个神经元都必须有激活函数。它们为神经元提供了模拟复杂非线性数据集所必需的非线性特性。该函数取所有输入的加权和,进而生成一个输出信号。你可以把它看作输入和输出之间的转换。使用适当的激活函数,可以将输出值限定在一个定义的范围内。如果 xi 是…

机器学习笔记 - Swish激活函数的定义和优势

一、Swish激活函数简述 首先,Swish 是像 ReLU、sigmoid 和 tanh 一样的非线性函数,使神经网络能够对输入和输出之间的复杂关系进行建模。非线性函数对于深度学习的工作至关重要,因为它们能够捕获和表示复杂的模式。 与 ReLU 等其他常用激活函数相比,Swish 具有独特的形状。…

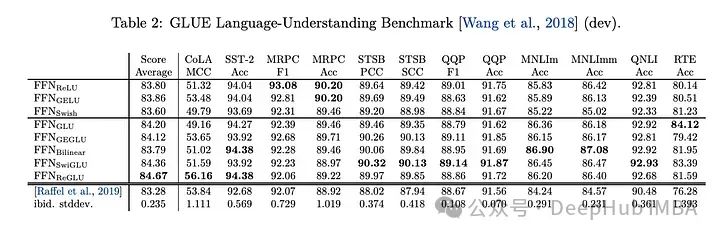

激活函数总结(八):基于Gate mechanism机制的激活函数补充(GLU、SwiGLU、GTU、Bilinear、ReGLU、GEGLU)

激活函数总结(八):基于Gate mechanism机制的激活函数补充 1 引言2 激活函数2.1 GLU激活函数2.2 SwiGLU激活函数2.3 GTU激活函数2.4 Bilinear激活函数2.5 ReGLU激活函数2.6 GEGLU激活函数 3. 总结 1 引言

在前面的文章中已经介绍了介绍了一系…

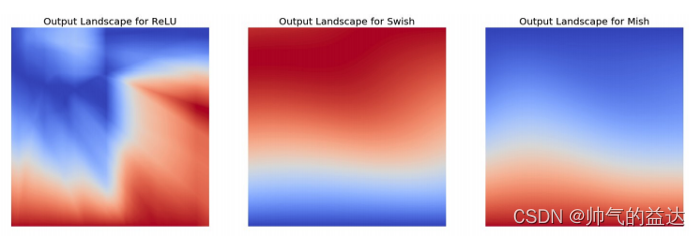

激活函数小结:ReLU、ELU、Swish、GELU等

文章目录 SigmoidTanhReLULeaky ReLUPReLUELUSoftPlus MaxoutMishSwishGELUSwiGLUGEGLU资源 激活函数是神经网络中的非线性函数,为了增强网络的表示能力和学习能力,激活函数有以下几点性质: 连续且可导(允许少数点上不可导&#x…

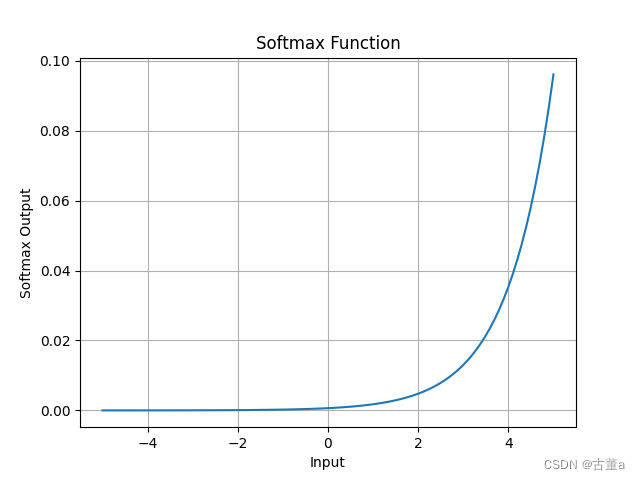

激活函数总结(九):Softmax系列激活函数补充(Softmin、Softmax2d、Logsoftmax)

激活函数总结(九):Softmax系列激活函数补充 1 引言2 激活函数2.1 Softmin激活函数2.2 Softmax2d激活函数2.3 Logsoftmax激活函数 3. 总结 1 引言

在前面的文章中已经介绍了介绍了一系列激活函数 (Sigmoid、Tanh、ReLU、Leaky ReLU、PReLU、S…

【AI】深度学习——人工智能、深度学习与神经网络

文章目录 0.1 如何开发一个AI系统0.2 表示学习(特征处理)0.2.1 传统特征学习特征选择过滤式包裹式 L 1 L_1 L1 正则化 特征抽取监督的特征学习无监督的特征学习 特征工程作用 0.2.2 语义鸿沟0.2.3 表示方式关联 0.2.4 表示学习对比 0.3 深度学习0.3.1 表示学习与深度学习0.3.…

深度学习入门——神经网络激活函数之sigmoid函数

sigmoid函数:

import numpy as np

import matplotlib.pyplot as pltdef sigmoid(x):return 1 / (1 np.exp(-x))x np.arange(-5, 5, 0.1)

y sigmoid(x)plt.plot(x, y)

plt.ylim(-0.1, 1.1) # 指定y轴的范围

plt.title(sigmoid)

plt.xlabel(x)

plt.ylabel(y)

plt…

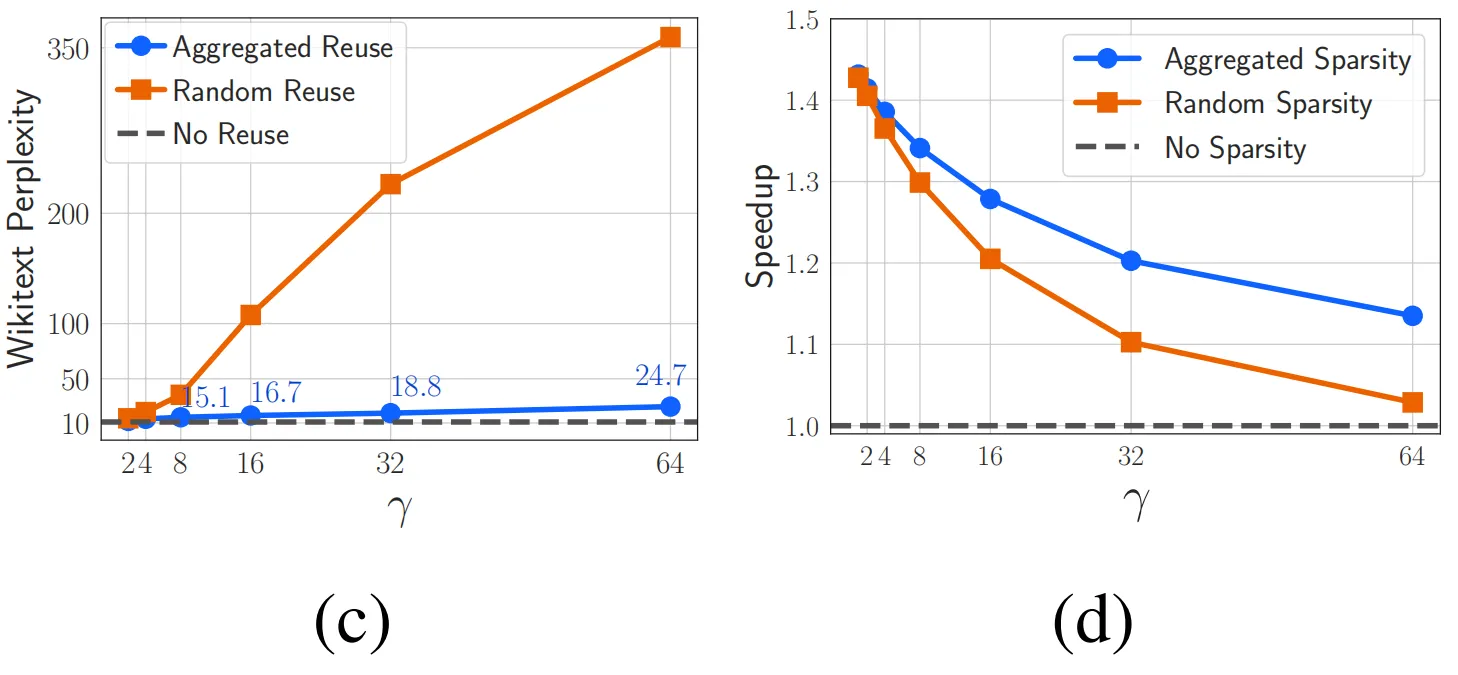

ICLR 2024|ReLU激活函数的反击,稀疏性仍然是提升LLM效率的利器

论文题目: ReLU Strikes Back: Exploiting Activation Sparsity in Large Language Models 论文链接: https://arxiv.org/abs/2310.04564 参数规模超过十亿(1B)的大型语言模型(LLM)已经彻底改变了现阶段人工…

深度学习中常用激活函数介绍

深度学习中常用激活函数介绍 在深度学习中,激活函数的作用主要是引入非线性特性,提高模型的表达能力。具体如下:

解决线性不可分问题:激活函数可以将输入特征的复杂度提升,使得神经网络能够处理非线性问题,…

Activation Functions in Neural Networks

This article is inspired by 这里 and 这里.

- 激活函数的主要意义是为NN加入非线性的元素。在神经学上模仿的是一个神经元是否有效。 A Neural Network without Activation function would simply be a Linear regression Model. Neural-Networks are considered Universal …

激活函数总结(十八):激活函数补充(RBF、SQ-RBF)

激活函数总结(十八):激活函数补充 1 引言2 激活函数2.1 Radial Basis Function (RBF)激活函数2.2 Square Radial Basis Function(SQ-RBF)激活函数 3. 总结 1 引言

在前面的文章中已经介绍了介绍了一系列激活函数 (Sig…

pytorch中的激活函数详解

1 激活函数介绍

1.1 什么是激活函数 激活函数是神经网络中引入的非线性函数,用于捕获数据中的复杂关系。它来自动物界的灵感,动物的神经元会接受来自对它有作用的其他神经元的信号,当然这些信号对该神经元的作用大小不同(即具有不…

【概念梳理】激活函数

一、引言

常用的激活函数如下: 1、Sigmoid函数 2、Tanh函数 3、ReLU函数 4、ELU函数 5、PReLU函数 6、Leaky ReLU函数 7、Maxout函数 8、Mish函数

二、激活函数的定义 多层神经网络中,上层节点的输出和下层节点的输入之间具有一个函数关系,…

激活函数总结(四十二):激活函数补充(SSFG、Gumbel Cross Entropy)

激活函数总结(四十二):激活函数补充 1 引言2 激活函数2.1 SSFG激活函数2.2 Gumbel Cross Entropy激活函数 3. 总结 1 引言

在前面的文章中已经介绍了介绍了一系列激活函数 (Sigmoid、Tanh、ReLU、Leaky ReLU、PReLU、Swish、ELU、SELU、GELU…

激活函数总结(三十二):激活函数补充(Serf、FReLU)

激活函数总结(三十二):激活函数补充 1 引言2 激活函数2.1 Serf激活函数2.2 FReLU激活函数 3. 总结 1 引言

在前面的文章中已经介绍了介绍了一系列激活函数 (Sigmoid、Tanh、ReLU、Leaky ReLU、PReLU、Swish、ELU、SELU、GELU、Softmax、Soft…

激活函数总结(二十一):激活函数补充(APL、Inverse Cubic)

激活函数总结(二十一):激活函数补充 1 引言2 激活函数2.1 Adaptive piecewise linear(APL)激活函数2.2 Inverse Cubic激活函数 3. 总结 1 引言

在前面的文章中已经介绍了介绍了一系列激活函数 (Sigmoid、Tanh、ReLU、…

【神经网络 基本知识整理】(激活函数) (梯度+梯度下降+梯度消失+梯度爆炸)

神经网络 基本知识整理 激活函数sigmoidtanhsoftmaxRelu 梯度梯度的物理含义梯度下降梯度消失and梯度爆炸 激活函数

我们知道神经网络中前一层与后面一层的连接可以用y wx b表示,这其实就是一个线性表达,即便模型有无数的隐藏层,简化后依旧…

激活函数,损失函数,正则化

激活函数简介

在深度学习中,输入值和矩阵的运算是线性的,而多个线性函数的组合仍然是线性函数,对于多个隐藏层的神经网络,如果每一层都是线性函数,那么这些层在做的就只是进行线性计算,最终效果和一个隐藏…

深度学习4大激活函数

如果不用激励函数(其实相当于激励函数是f(x) x),在这种情况下你每一层输出实际上都是上层输入的线性函数。

这样就使得无论神经网络有多少层,输出都是输入的线性组合,与没有隐藏层效果相当,模型的表达力仍…

为什么大型语言模型都在使用 SwiGLU 作为激活函数?

如果你一直在关注大型语言模型的架构,你可能会在最新的模型和研究论文中看到“SwiGLU”这个词。SwiGLU可以说是在大语言模型中最常用到的激活函数,我们本篇文章就来对他进行详细的介绍。SwiGLU其实是2020年谷歌提出的激活函数,它结合了SWISH和…

激活函数(Sigmoid, tanh, Relu)

重新看了一下,发现写的时候思绪乱了也没有检查。现在重新更改,特别是输出不以零为中心(non-zero center)的问题。 按照进程这章总结的是激活函数(Activation Function)。其实这节CS231n讲的就很细了,但是!&…

深度学习入门——神经网络激活函数之阶跃函数

import numpy as np

import matplotlib.pyplot as pltdef step_function(x):return np.array(x > 0, dtypenp.int)x np.arange(-0.5, 0.5, 0.01)

y step_function(x)plt.plot(x, y)

plt.ylim(-0.1, 1.1) # 指定y轴的范围

plt.ylabel(y)

plt.xlabel(x)

plt.title(step func…

pytorch-多层感知机,最简单的深度学习模型,将非线性激活函数引入到模型中。

多层感知机,线性回归和softmax回归在内的单层神经网络。然而深度学习主要关注多层模型。在本节中,我们将以多层感知机(multilayer perceptron,MLP)为例,介绍多层神经网络的概念。 隐藏层 多层感知机在单层…

理解神经网络的数学原理(三)激活函数的作用

概述

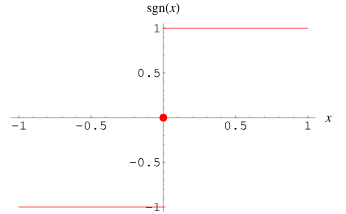

理解激活函数的作用能更好的解释神经网络的运行逻辑,在以前的章节中只简单概述了激活函数的作用,但是其实结论是比较草率的,这篇文章希望能谨慎的证明这些结论。 s i g n sign sign 激活函数

一般我们都直接在分类的全连接层ÿ…

【动手学深度学习】深入浅出深度学习之线性神经网络

目录

🌞一、实验目的

🌞二、实验准备

🌞三、实验内容

🌼1. 线性回归

🌻1.1 矢量化加速

🌻1.2 正态分布与平方损失

🌼2. 线性回归的从零开始实现

🌻2.1. 生成数据集

&#x…

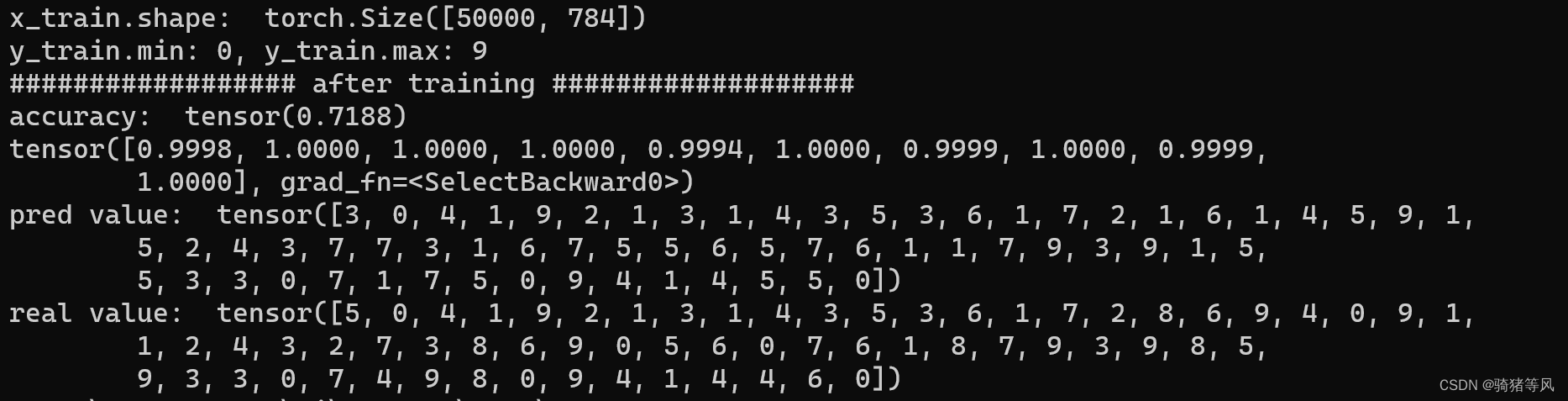

PyTorch官网demo解读——第一个神经网络(4)

上一篇:PyTorch官网demo解读——第一个神经网络(3)-CSDN博客 上一篇我们聊了手写数字识别神经网络的损失函数和梯度下降算法,这一篇我们来聊聊激活函数。

大佬说激活函数的作用是让神经网络产生非线性,类似人脑神经元…

有趣的数学 sign是什么函数

在数学中,函数sign指的是符号函数,它的定义如下:对于任意实数x,若x>0,则sign(x)1;若x0,则sign(x)0;若x<0,则sign(x)-1;简单来说,sign函数就…

机器学习-神经网络之激活函数(Activation Function)

日常 coding 中,我们会很自然的使用一些激活函数,比如:sigmoid、ReLU等等。不过好像忘了问自己一(n)件事:

为什么需要激活函数?激活函数都有哪些?都长什么样?有哪些优缺点?怎么选用…

激活函数总结(十五):振荡系列激活函数补充(SQU、NCU、DSU、SSU)

激活函数总结(十五):激活函数补充 1 引言2 激活函数2.1 Shifted Quadratic Unit (SQU) 激活函数2.2 Non-Monotonic Cubic Unit (NCU) 激活函数2.3 Decaying Sine Unit (DSU) 激活函数2.4 Shifted Sinc Unit (SSU) 激活函数 3. 总结 1 引言

在…

计算机视觉与深度学习-全连接神经网络-激活函数- [北邮鲁鹏]

文章目录 基础知识为什么需要非线性操作(激活函数)?激活函数 vs 数据预处理常用的激活函数Sigmoid函数 (Logistic函数)双曲正切函数(Tanh函数)线性整流函数(ReLU函数)Lea…

A.深度学习基础入门篇[四]:激活函数介绍:tanh、sigmoid、ReLU、PReLU、ELU、softplus、softmax、swish等

1.激活函数 激活函数是人工神经网络的一个极其重要的特征; 激活函数决定一个神经元是否应该被激活,激活代表神经元接收的信息与给定的信息有关; 激活函数对输入信息进行非线性变换,然后将变换后的输出信息作为输入信息传给下一层…

激活函数总结(十七):激活函数补充(PELU、Phish)

激活函数总结(十七):激活函数补充 1 引言2 激活函数2.1 Parametric Exponential Linear Unit(PELU)激活函数2.2 Phish激活函数 3. 总结 1 引言

在前面的文章中已经介绍了介绍了一系列激活函数 (Sigmoid、Tanh、ReLU、…

neural network for machine learning(by Geoffrey Hinton)lecture1--几种常见的激活函数

neural network for machine learning(by Geoffrey Hinton)lecture1--几种常见的激活函数 看了Hinton大神在第一周的lecture1中的讲的几种激活函数,自己又搜集了一些资料,因此整理成一篇博客,一来相当于笔记方便自己查…

激活函数总结(十六):激活函数补充(SReLU、BReLU)

激活函数总结(十六):激活函数补充 1 引言2 激活函数2.1 S-shaped Rectified Linear Activation Unit(SReLU)激活函数2.2 Bipolar Rectified Linear Unit (BReLU)激活函数 3. 总结 1 引言

在前面的文章中已经介绍了介绍…

激活函数总结(十九):激活函数补充(ISRU、ISRLU)

激活函数总结(十九):激活函数补充 1 引言2 激活函数2.1 Inverse Square Root Unit (ISRU)激活函数2.2 Inverse Square Root Linear Unit (ISRLU)激活函数 3. 总结 1 引言

在前面的文章中已经介绍了介绍了一系列激活函…

激活函数总结(十四):激活函数补充(Gaussian 、GCU、ASU)

激活函数总结(十四):激活函数补充 1 引言2 激活函数2.1 Gaussian 激活函数2.2 Growing Cosine Unit (GCU)激活函数2.3 Amplifying Sine Unit (ASU)激活函数 3. 总结 1 引言

在前面的文章中已经介绍了介绍了一系列激活函数 (Sigmoid、Tanh、R…

神经网络常用激活函数详解

🎀个人主页: https://zhangxiaoshu.blog.csdn.net 📢欢迎大家:关注🔍点赞👍评论📝收藏⭐️,如有错误敬请指正! 💕未来很长,值得我们全力奔赴更美好的生活&…

激活函数总结(四十六):激活函数补充(Nipuna、StarReLU)

激活函数总结(四十六):激活函数补充 1 引言2 激活函数2.1 Nipuna激活函数2.2 StarReLU激活函数 3. 总结 1 引言

在前面的文章中已经介绍了介绍了一系列激活函数 (Sigmoid、Tanh、ReLU、Leaky ReLU、PReLU、Swish、ELU、SELU、GELU、Softmax、…

梯度消失问题与如何选择激活函数

梯度消失问题与如何选择激活函数 什么是梯度消失?梯度消失有什么影响?是什么原因?解决方案有哪些?如何选择激活函数? 1. 什么是梯度消失?

梯度消失,常常发生在用基于梯度的方法训练神经网络的过…

激活函数总结(十二):三角系列激活函数补充(Sinusoid、Cosine、Arcsinh、Arccosh、Arctanh)

激活函数总结(十二):三角系列激活函数补充 1 引言2 激活函数2.1 Sinusoid激活函数2.2 Cosine激活函数2.3 Arc系列激活函数 3. 总结 1 引言

在前面的文章中已经介绍了介绍了一系列激活函数 (Sigmoid、Tanh、ReLU、Leaky ReLU、PReLU、Swish、…

激活函数总结(三十):激活函数补充(Logit、Softsign)

激活函数总结(三十):激活函数补充 1 引言2 激活函数2.1 Logit激活函数2.2 Softsign激活函数 3. 总结 1 引言

在前面的文章中已经介绍了介绍了一系列激活函数 (Sigmoid、Tanh、ReLU、Leaky ReLU、PReLU、Swish、ELU、SELU、GELU、Softmax、So…

PyTorch----激活函数

什么是激活函数? 在神经网络中我们经常使用线性运算来解决分类问题,这就需要激活函数来解决非线性问题 传统的全连接网络是让数据不断的通过线性函数和激活函数层,从而得到最终的预测结果。 Sigmoid函数

sigmoid函数是最经典、最早使用的…

深度学习:激活函数曲线总结

深度学习:激活函数曲线总结

在深度学习中有很多时候需要利用激活函数进行非线性处理,在搭建网路的时候也是非常重要的,为了更好的理解不同的激活函数的区别和差异,在这里做一个简单的总结,在pytorch中常用的激活函数的…

深度学习:Sigmoid函数与Sigmoid层区别

深度学习:Sigmoid函数与Sigmoid层

1. Sigmoid神经网络层 vs. Sigmoid激活函数

在深度学习和神经网络中,“Sigmoid” 是一个常见的术语,通常用来表示两个相关但不同的概念:Sigmoid激活函数和Sigmoid神经网络层。这两者在神经网络…

![A.深度学习基础入门篇[四]:激活函数介绍:tanh、sigmoid、ReLU、PReLU、ELU、softplus、softmax、swish等](https://img-blog.csdnimg.cn/img_convert/15b2ac3be28f3d779b5f6ef2379ea519.png)